728x90

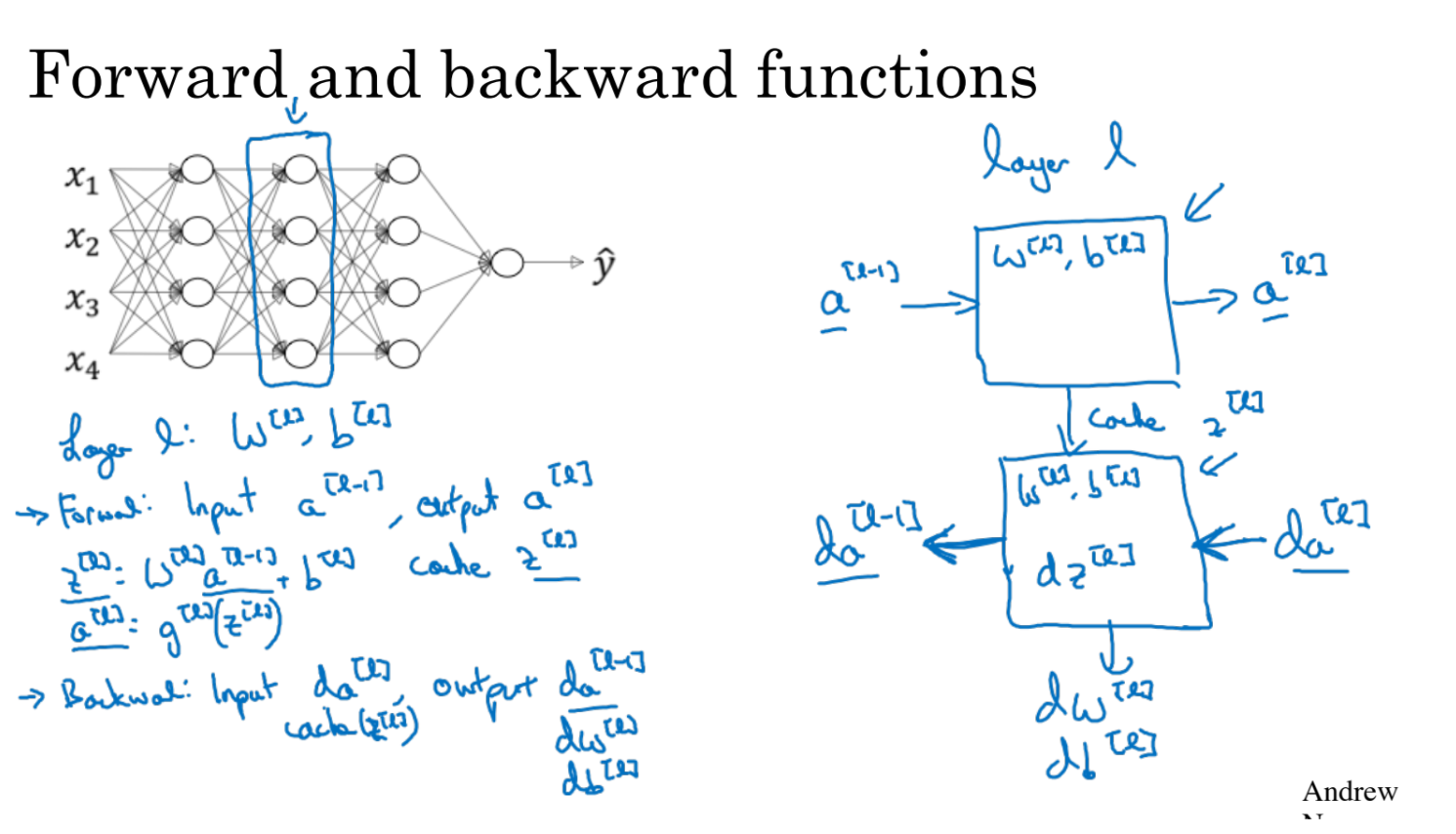

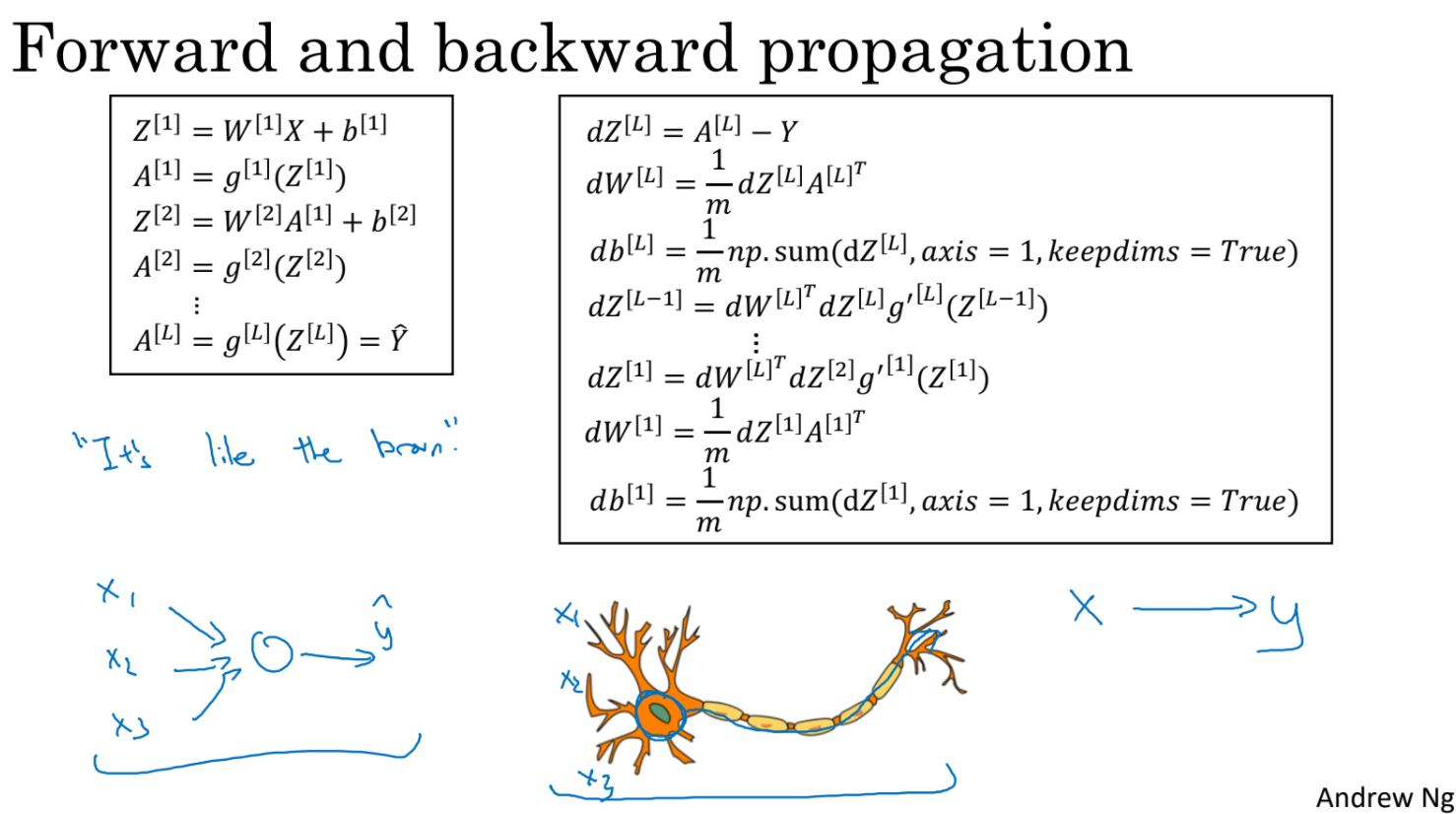

- 하나의 layer만 떼서 forward, backward propagation을 구현을 해보자.

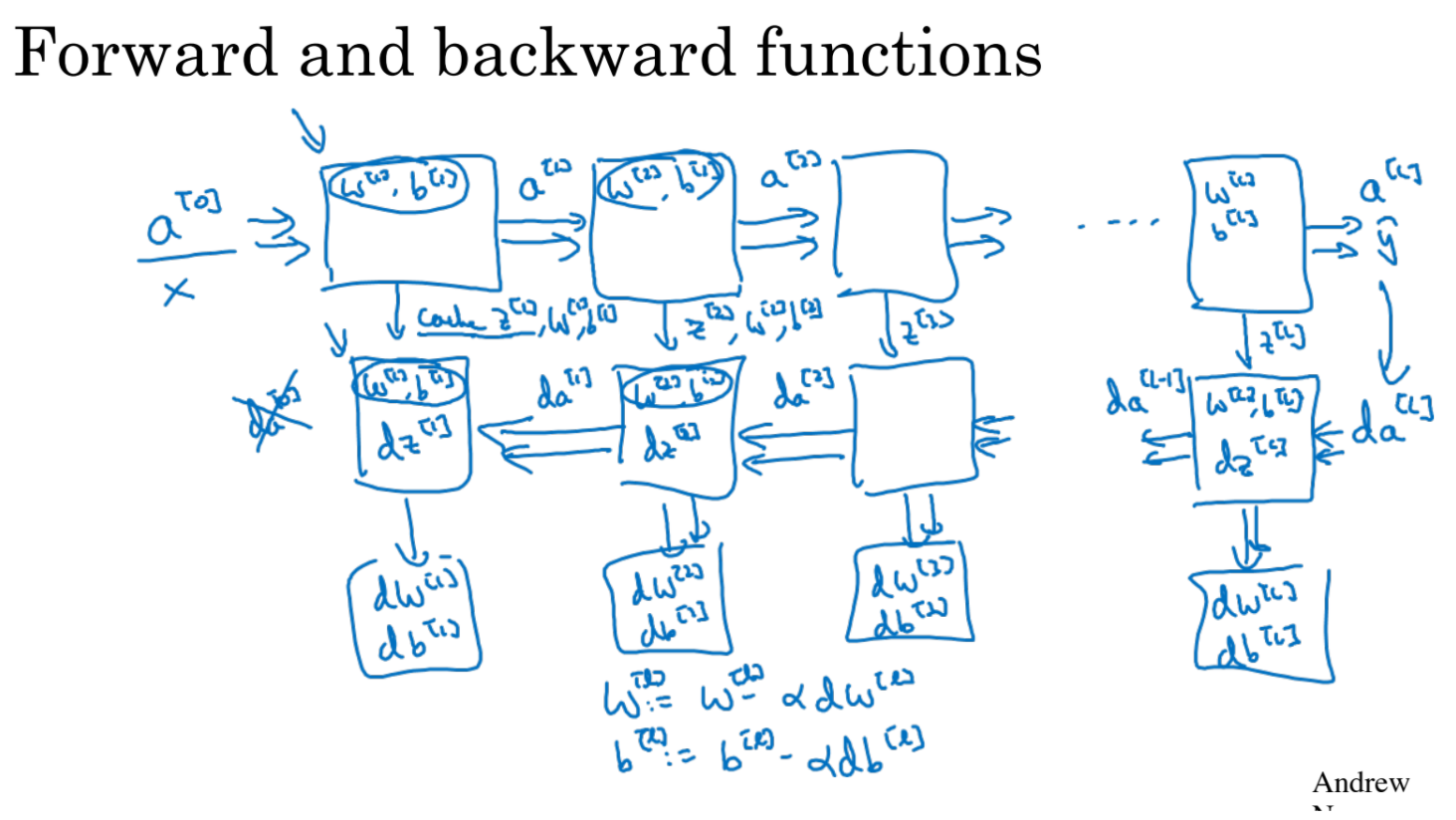

- 우측으로 layer들을 거치면서 y^을 구한다.

- 이제 cost를 가지고 왼쪽으로 layer들을 거치면서 각 weight, bias를 갱신한다.

- 각 layer들의 계산 결과인 z, w, b를 cache에 저장해두면 나중에 backward propagation할때 유리하다.

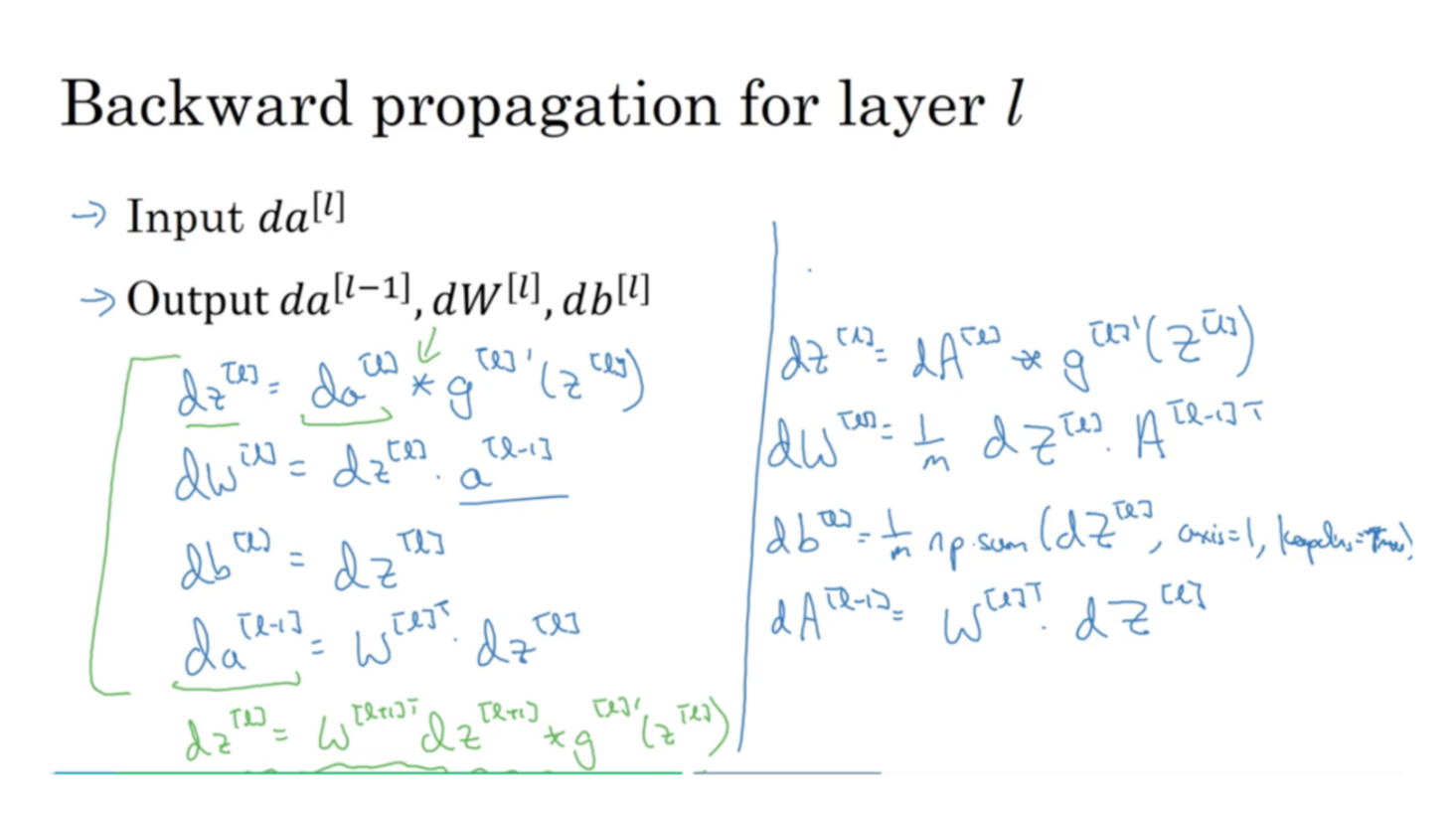

- deep neural network에서 backward propagation을 살펴보자.

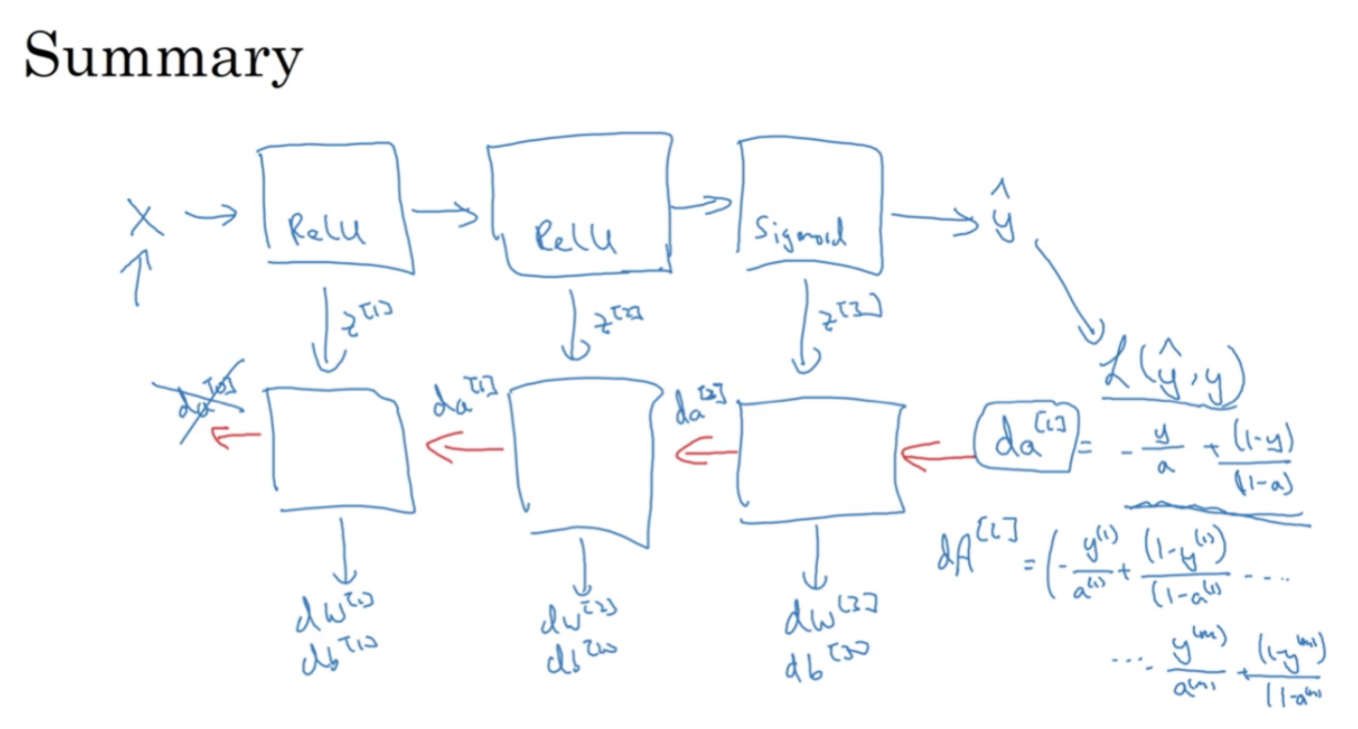

- 모든 과정을 정리하면 위와 같다.

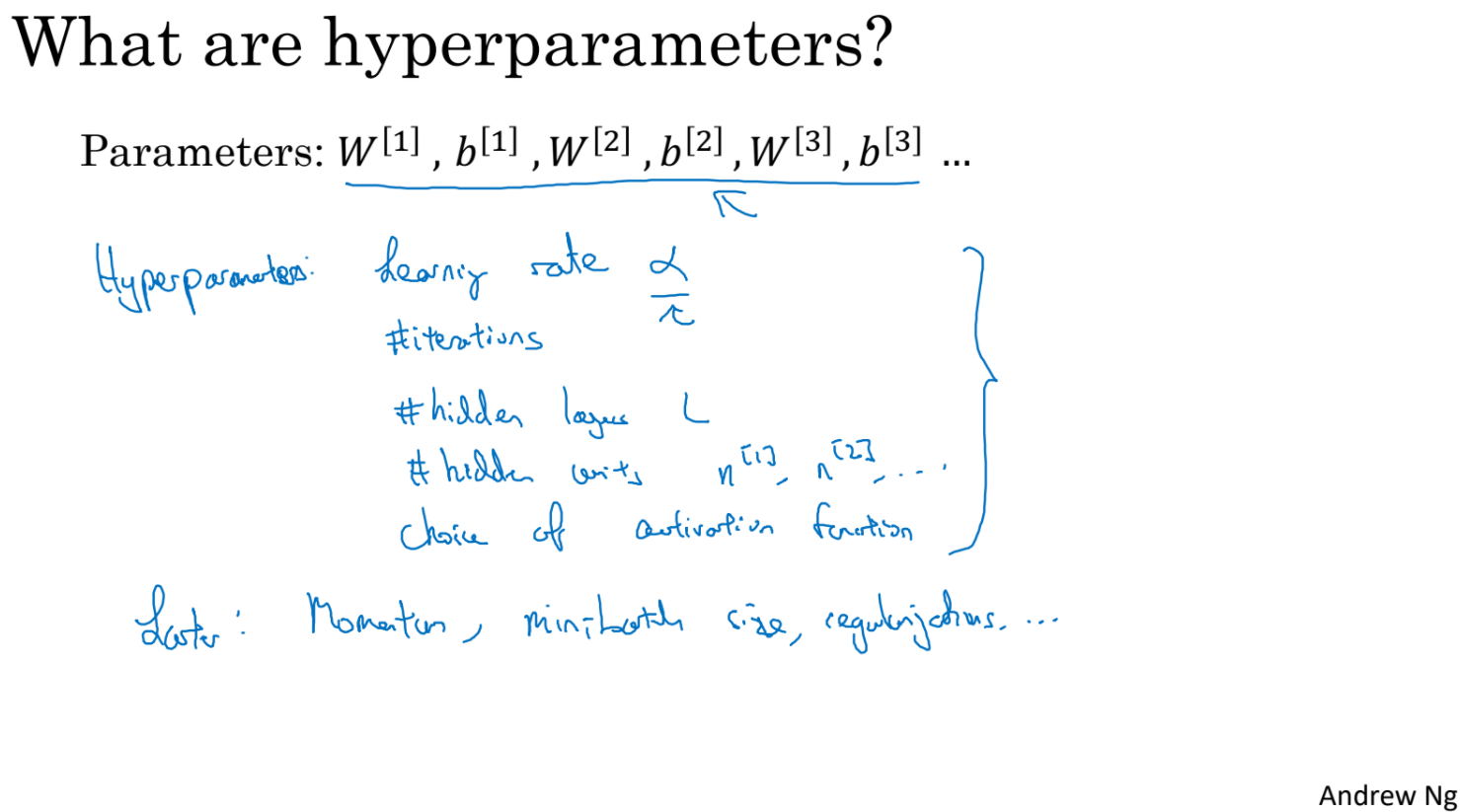

- w,b말고도 다른 parameter들이 필요하다. 이를 hyper parameter라고 한다.

- learning rate alpha. activation function, #hidden layer 등 최종 w,b를 조정하기위해 많은 매개변수들이 사용된다.

- 모델을 구축하는 과정은 empirical한 과정이다. 계속해서 경험적으로 최적의 output을 위해 hyper parameter들을 조정해보아야 한다.

- brain의 single biological neuron을 단순화하고 단순화한 모델과 logistic regression unit을 비교해보자.

- 아직은 human brain의 뉴런이 어떤 알고리즘으로 신호를 해석해서 전기신호로 흘려보내는지는 모르지만 직관적으로 유사한 면을 살펴볼 수 있다.

728x90

반응형

'ComputerScience > Machine Learning' 카테고리의 다른 글

| AI - 4. 전문가 시스템 (0) | 2021.09.17 |

|---|---|

| AI - 3. 탐색 응용 (0) | 2021.09.16 |

| Deep Learning 1-4-1 (0) | 2021.09.14 |

| Deep Learning 1-3-2 (0) | 2021.09.14 |

| Deep Learning 1-3-1 (0) | 2021.09.10 |