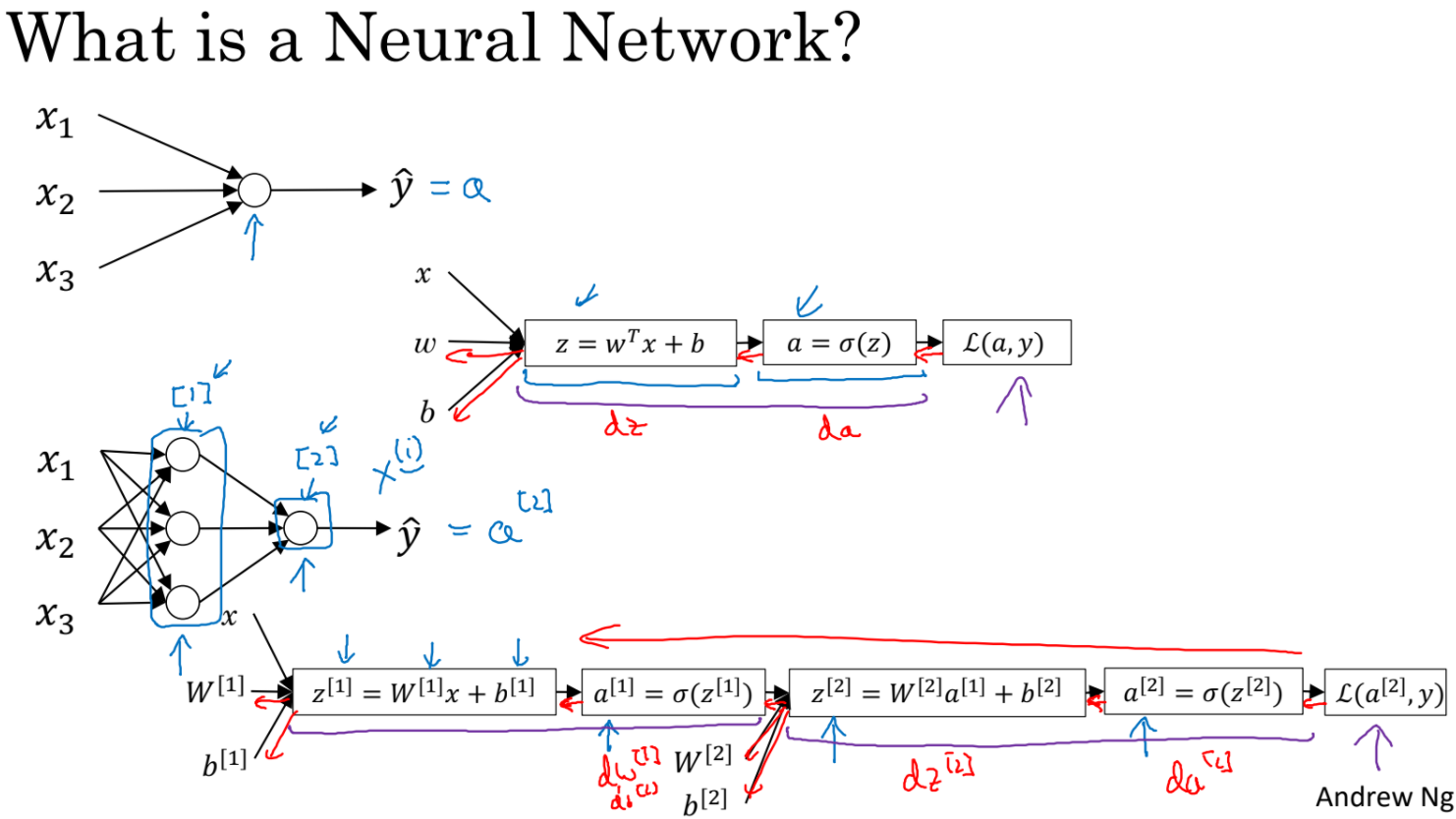

- Neural Network는 이전 시간에서 배운 neuron(logistic regression unit)들을 쌓은 것이다.

- neuron에서 y^, 즉 a를 구하고 Loss를 계산했다.

- 그림에서의 neural network는 layer[1]에서 결과들을 가지고 layer[2]에서 한번더 계산해서 y^을 구한다.

- Loss를 가지고 backward하면서 gradient를 구한다.

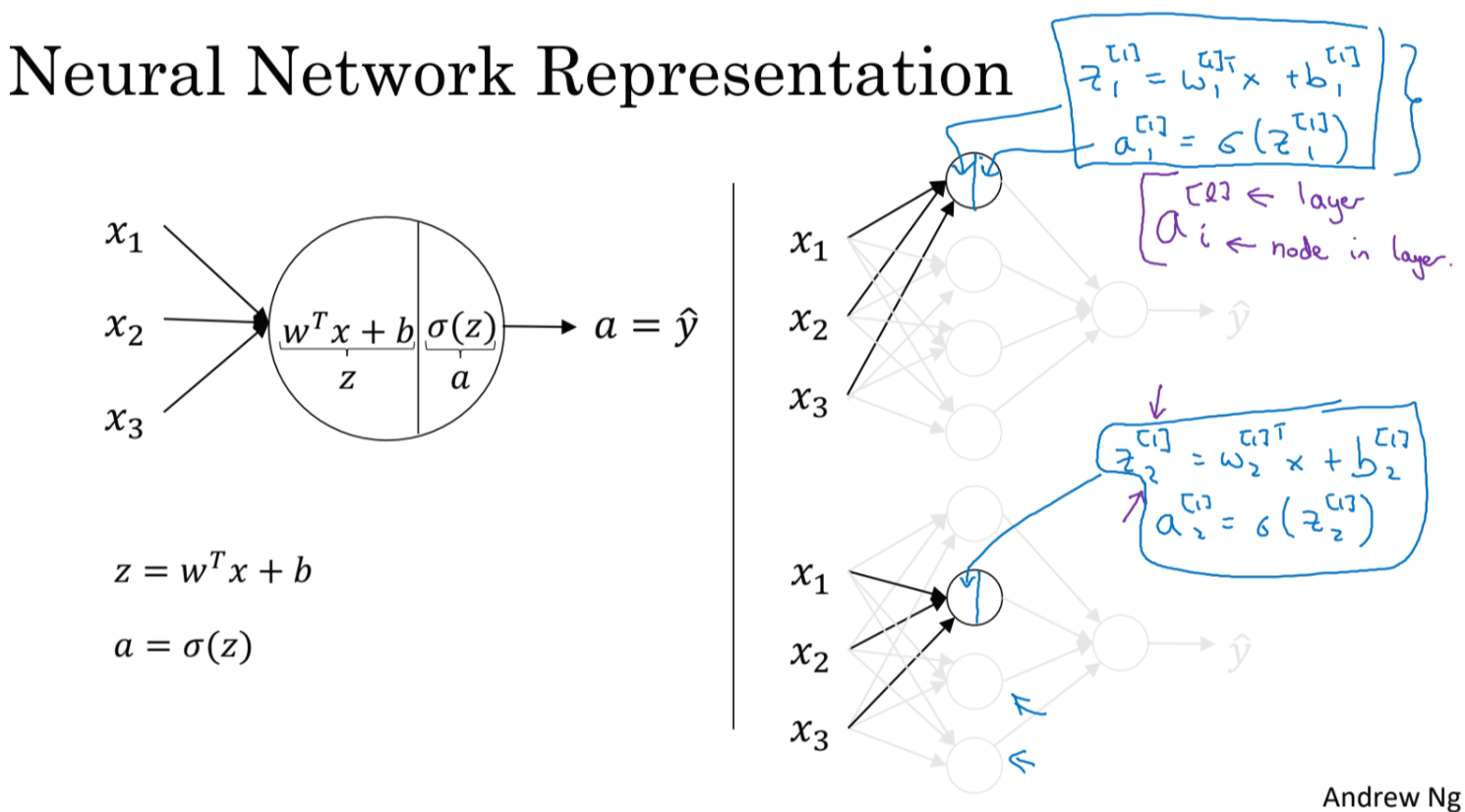

- x1,x2,x3들이 input features이다. 이 layer를 input layer라고 부른다.

- hidden layer : 학습도중에 값들이 관찰되지 않기 때문에 hidden이라고 부른다.

- 결과값을 반환하는 layer를 output layer라고 한다.

- 위 그림은 2 layer Neural Network이다. input layer는 세지 않는다.

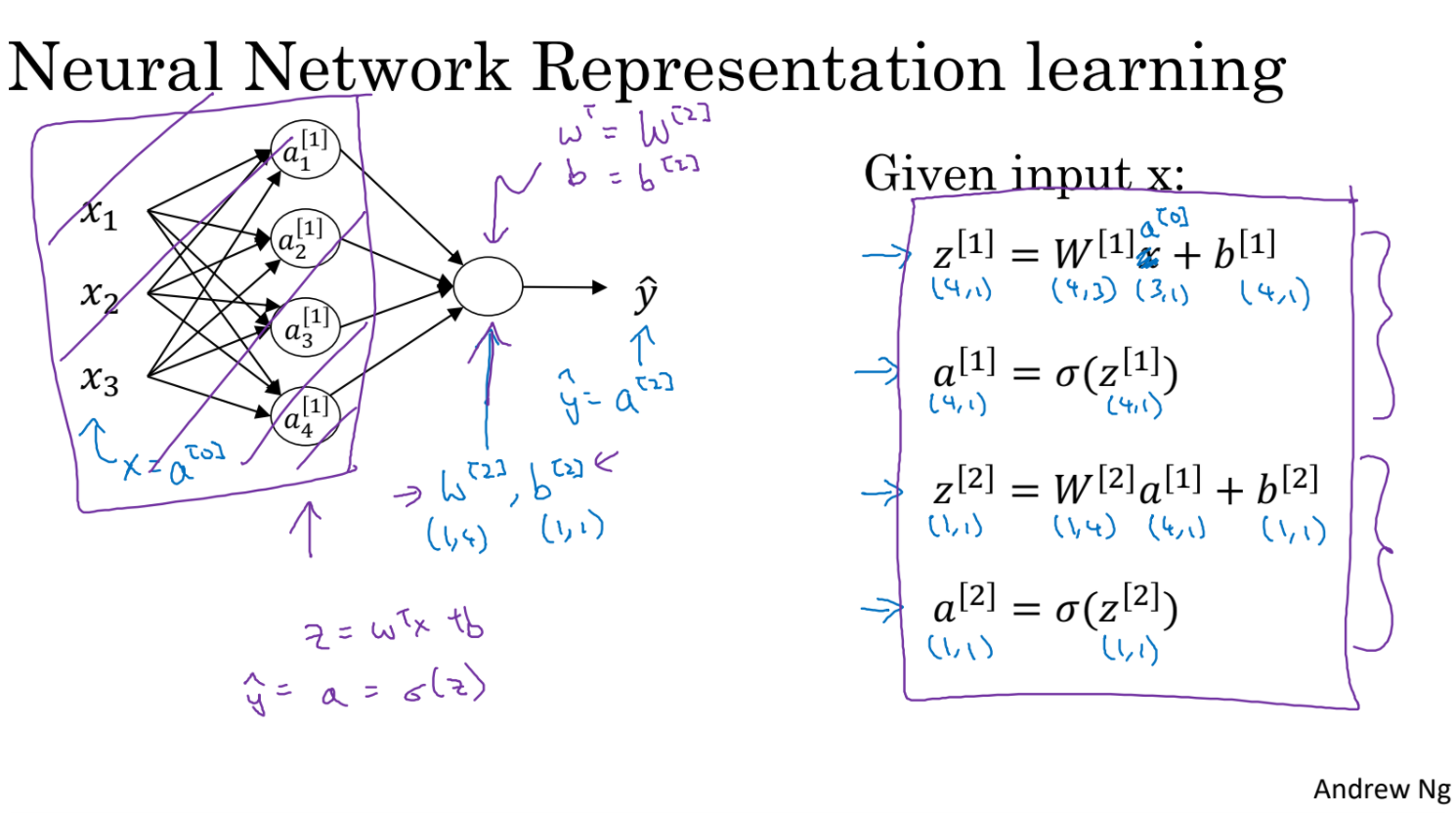

- Hiden Layer는 파라미터로 w[1],b[1] matrix를 갖는다. 크기는 (4,3)/(4,1)이다

- output layer는 파라미터로 w[2],b[2]를 갖는다. 크기는 (1,4), (1,1)이다

- hiden Layer 에서의 계산 식을 matrix equation으로 도출해본다.

- z[1]을 구하고 sigmoid를 씌워 a[1]을 찾는다.

- 이번에는 output layer의 계산식을 살펴보자.

- a[1]으로 z[2]를 구하고 sigmoid를 씌워 a[2]를 구한다.

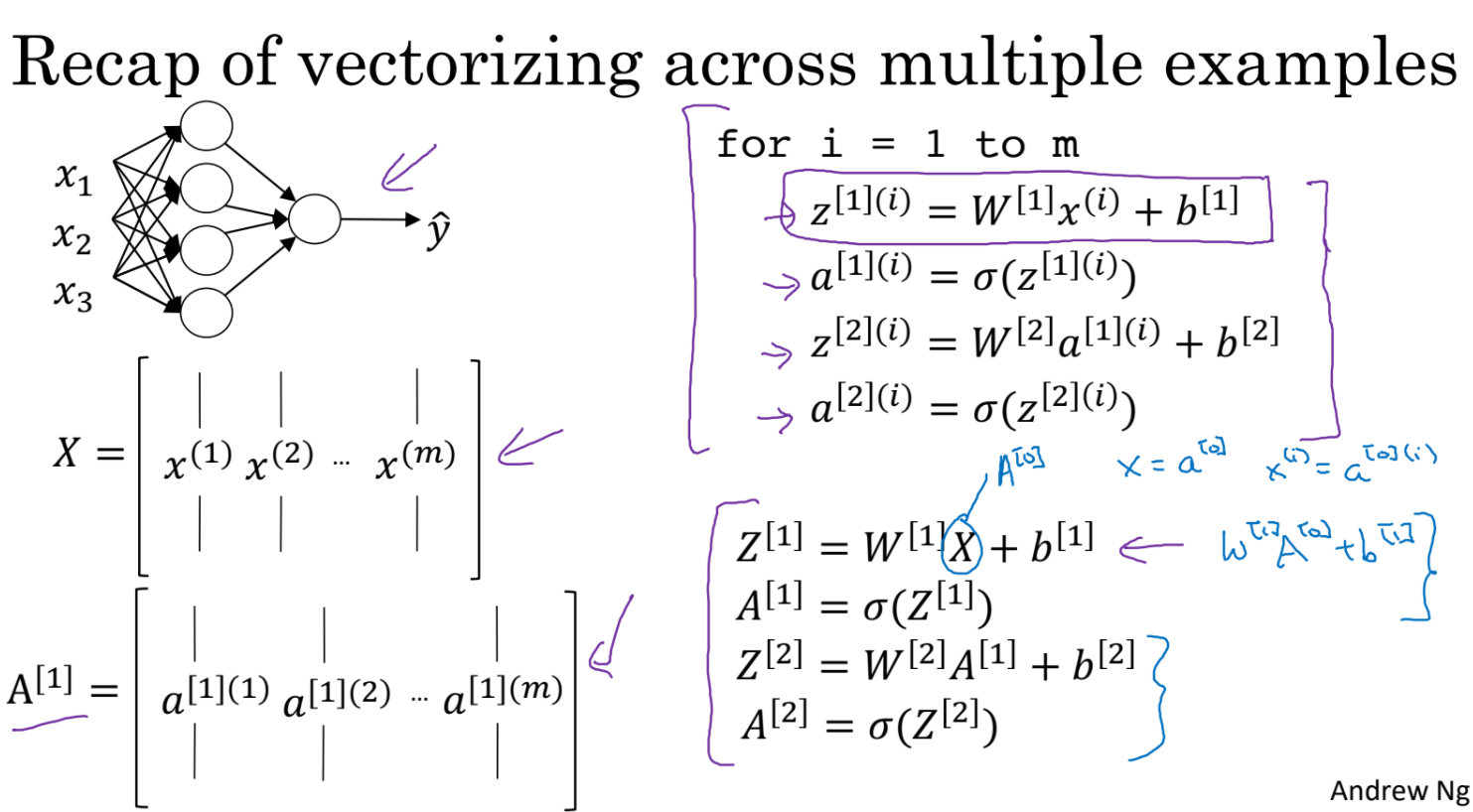

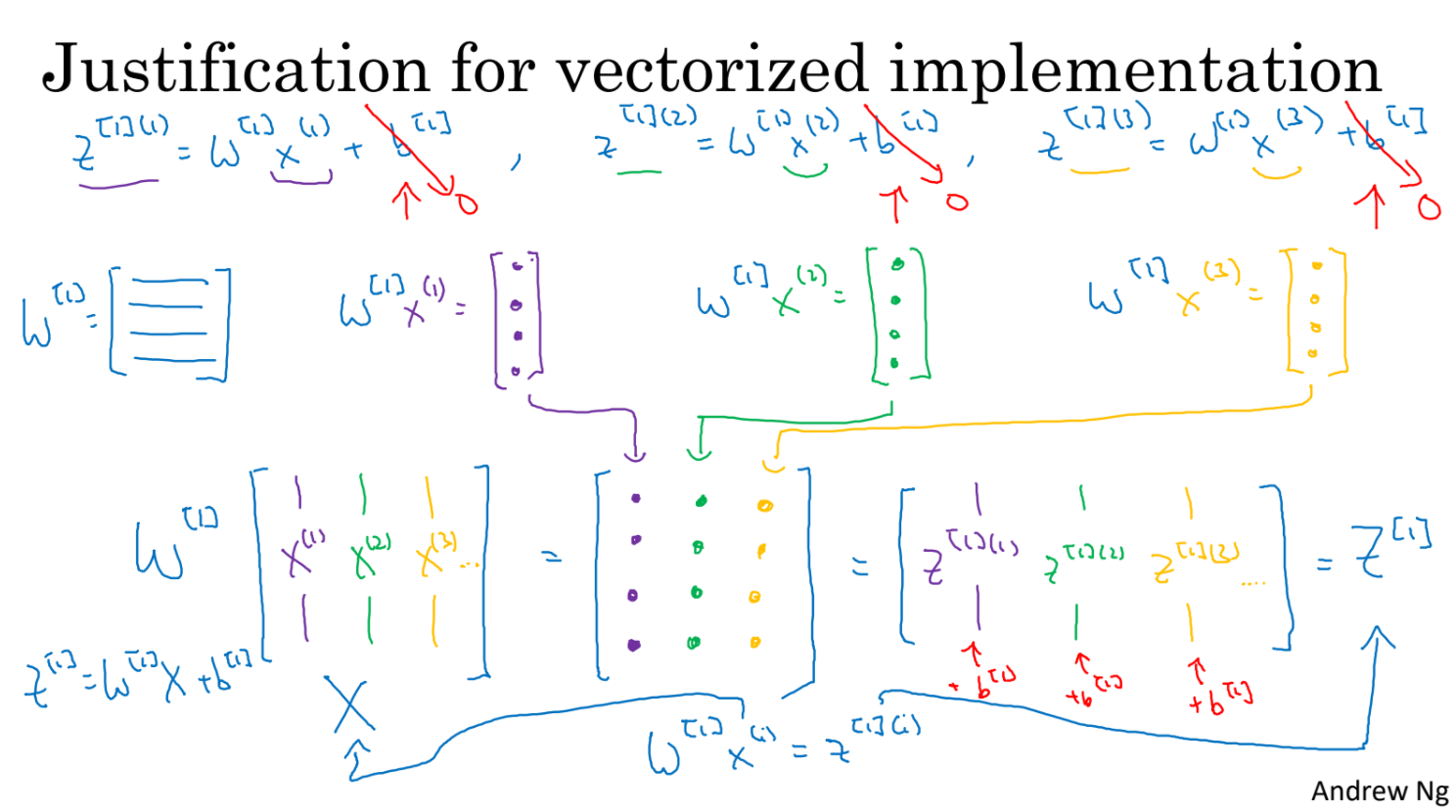

- 이제까지는 input이 x 벡터 하나인 예제만 살펴보았다.

- 이번에는 input x가 m개 있다고 생각해보자.

- 이제 vectorization으로 for문을 없애보자

'ComputerScience > Machine Learning' 카테고리의 다른 글

| Deep Learning 1-4-1 (0) | 2021.09.14 |

|---|---|

| Deep Learning 1-3-2 (0) | 2021.09.14 |

| AI - 2. Search (0) | 2021.09.09 |

| Deep Learning 1-2-2 (0) | 2021.09.07 |

| Deep Learning 1-2-1 (0) | 2021.09.07 |