728x90

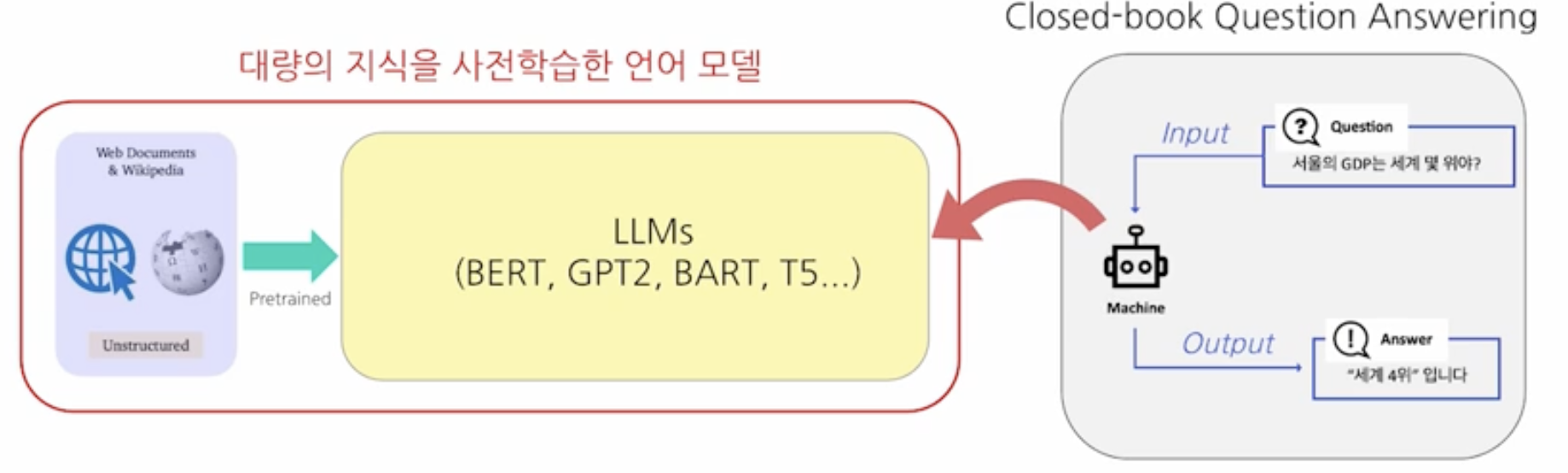

open domain question answering에서는 질문과 관련된 지문을 찾고 거기서 정답을 찾는 방식이였다.

closed book QA에서는 모델이 사전에 대량의 지식으로 학습되었다면 하나의 지식 저장 창고로써 기능할 수 있지 않을까?에서 출발한다. 사전에 학습한 내용에 기반해서 질문에 정답을 즉시 뱉는 것이다.

1. Text-to-text

T5에서 처음 제안한 방법이다. 모든 task의 문제를 test input으로 치환해서 한번에 학습시키는 것이다. T5에서도 mrc데이터셋을 가지고 finetuning을 수행하여 closed book qa에 사용해보았었다.

2. In-context Learning

parameter를 실제로 업데이트 하지는 않으나 Instruction과 예제를 input에 함께 추가하여 넣어줌으로써 모델이 보지 못한 데이터 혹은 처음보는 task에서도 문제를 풀 수 있도록 하였다.

모델이 reasoning과 generalization이 가능하고 사전 학습에서 factual knowledge를 습득하였기에 가능하다고 본다.

3. LoRA

finetuning을 할때 모든 파라미터를 다시 학습시키는 것을 부담스럽다. 따라서 일부만 업데이트하는 방법을 제안한 것이 LoRA이다.

hugging face 라이브러리를 사용한다면 정말 쉽게 LoRA를 통해 finetuning을 해볼 수 있다.

728x90

반응형

'boostcamp AI tech > boostcamp AI' 카테고리의 다른 글

| Airflow (0) | 2024.02.26 |

|---|---|

| Product Serving 관련 용어 정리 (0) | 2024.02.26 |

| Passage Retrieval - Scaling up, FAISS (0) | 2024.02.19 |

| Passage Retrieval - Dense Embedding (0) | 2024.02.16 |

| Passage Retrieval - Sparse Embedding, TF-IDF (1) | 2024.02.14 |